Korrekte technische Website-Komponenten bilden die Basis für die Suchmaschinenoptimierung und jeglichen On- und Off-Page-Massnahmen. Technisches SEO ist ein entscheidender Schritt in der gesamten SEO Optimierung. Dadurch wird die Sichtbarkeit der Website in der organischen Suche stark beeinflusst. Wird keines oder falsches technisches SEO praktiziert, kann es im schlimmsten Fall dazukommen, dass man im Suchmaschinen-Index nicht gelistet wird und komplett an organischer Sichtbarkeit verliert.

Deshalb ist technisches SEO wichtig! Heute zeigen wir euch die acht wichtigsten Komponenten vom technischen SEO:

1. Duplicate Content

Sind gleiche Textinhalte über mehrere URLs zugänglich, spricht man von Duplicate Content.

Gerade bei Onlineshops ist Duplicate Content ein gängiges Problem, da Produktbeschreibungen auf mehreren Seiten identisch sind. Für die Suchmaschinen ist Duplicate Content nicht optimal, da sie in den Suchergebnissen einzigartige Inhalte abbilden möchten. Verfügen Websites mehrfach über gleiche Inhalte, wird die Seite aufgrund fehlender Einzigartigkeit schlechter bewertet und es wird verhindert, bessere Rankingpositionen zu erzielen.

Bei gewissen Funktionalitäten oder CMS Konfigurationen lassen sich doppelte Inhalte nicht vermeiden. Hier bietet sich der Einsatz von Canonical Tags an. Damit können die Suchmaschinencrawler über die Originalquelle des Textes informiert werden und die Inhalte werden einmalig indexiert.

2. Page Speed

Die Nutzersignale gehören zu den wichtigsten Google Rankingfaktoren. Eine sehr wichtige Komponente, um, beispielsweise, die Verweildauer von Nutzerinnen und Nutzer zu beeinflussen und die Steuerung der Nutzersignale zu bilden, ist die Seitenladezeit. Um auf der Website eine positive User Experience zu erzielen, ist eine kurze Ladezeit essentiell.

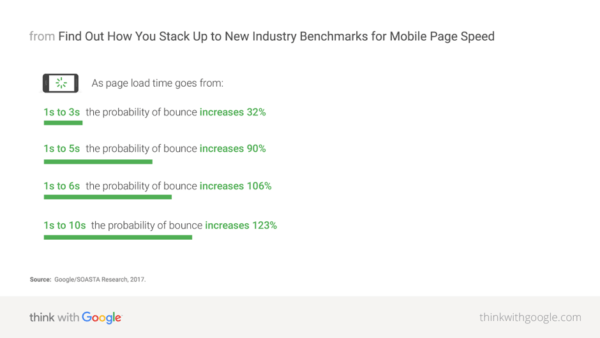

Wichtig: Anfang 2017 machte Google anhand einer Studie deutlich, dass die Ladezeit einen direkten Zusammenhang mit der Conversion Rate hat. Ist die Ladezeit einer Website länger als 3 Sekunden, springen 53% der Nutzer und Nutzerinnen ab und besuchen eine andere Website.

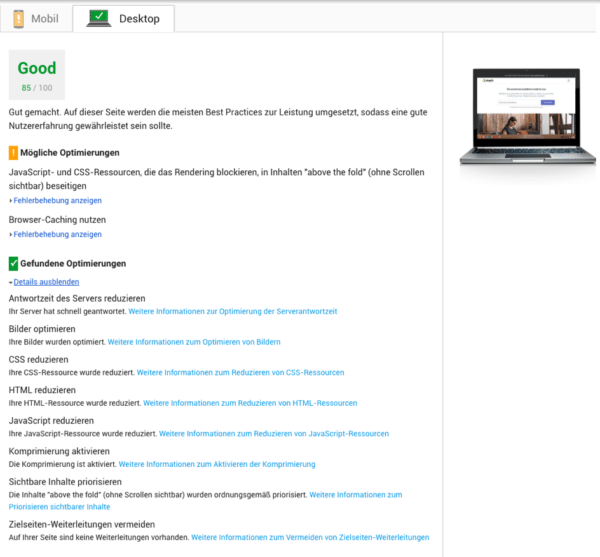

Zur Verbesserung der Seitenladezeit empfiehlt sich die Komprimierung von Inhalten. Grosse Bilder, viele Plugins und aufwendige Animationen verlangsamen die Seitenladezeit. Google bietet das Tool PageSpeed Insights an. Hier kann die Website-Geschwindigkeit gemessen werden und man erhält wertvolle Tipps, um die Seitengeschwindigkeit zu optimieren.

3. Crawling & Indexierung

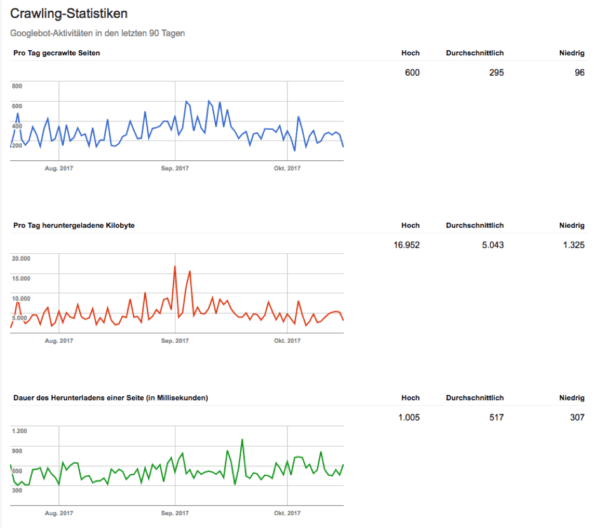

Jede Website verfügt über ein individuelles Crawling- und Indexierungsbudget. Diese definieren, wie häufig die Suchmaschinen-Crawler die Website besuchen und welche Anzahl an Seiten im Google Index gelistet werden. Um die Crawlings und die Indexierung zu optimieren, empfiehlt sich eine konkrete Analyse der URL Struktur. Anhand der Erkenntnisse aus einer solchen Analyse können SEO Agenturen bestimmen, welche Inhalte fürs Crawling und welche Inhalte für die Indexierung ausgeschlossen werden sollten. Dies ist wichtig um sicherzustellen, dass die wichtigen Seiten regelmässig gecrawlt und im Google Index platziert werden.

4. Sitemap

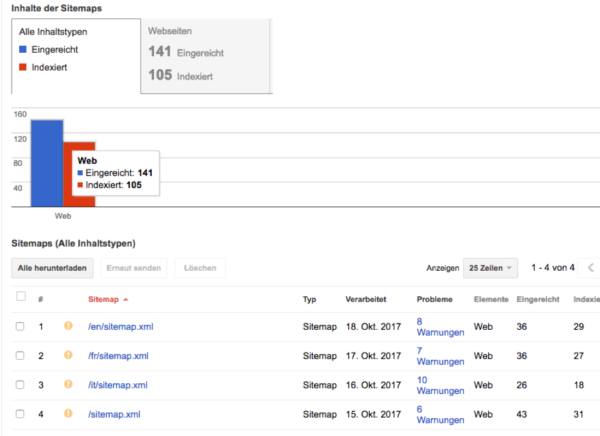

Um den Suchmaschinen-Bots das Crawling zu vereinfachen und somit Crawling-Budget einzusparen, sollte man kategorisierte und strukturierte XML-Sitemaps erstellen. Diese müssen stets aktuell gehalten und fehlerfrei sein. Mittels Verlinkung der Sitemaps in der robots.txt und Einreichung der Sitemaps über die Search Console kann sichergestellt werden, dass die Seiten wirklich gecrawlt werden.

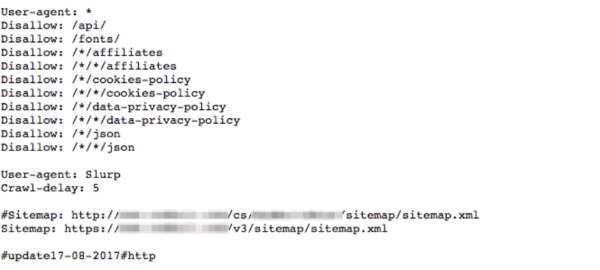

5. robots.txt

Die robots.txt ist eine Datei zur Steuerung der Suchmaschinen-Crawler. Mit dieser Datei wird festgelegt, welche Inhalte für die Bots zugänglich sind und welche gesperrt werden sollen. Da jede Website über ein individuelles Crawling-Budget verfügt, ist es sehr wichtig, dieses gezielt einzusetzen. Welche Seiten oder Verzeichnisse in der robots.txt gesperrt werden, ist von Seite zu Seite unterschiedlich. Beispielsweise werden bei Onlineshops häufig die Parameter in der robots.txt ausgeschlossen, welche über Sortier- und Filterfunktionen gebildet werden.

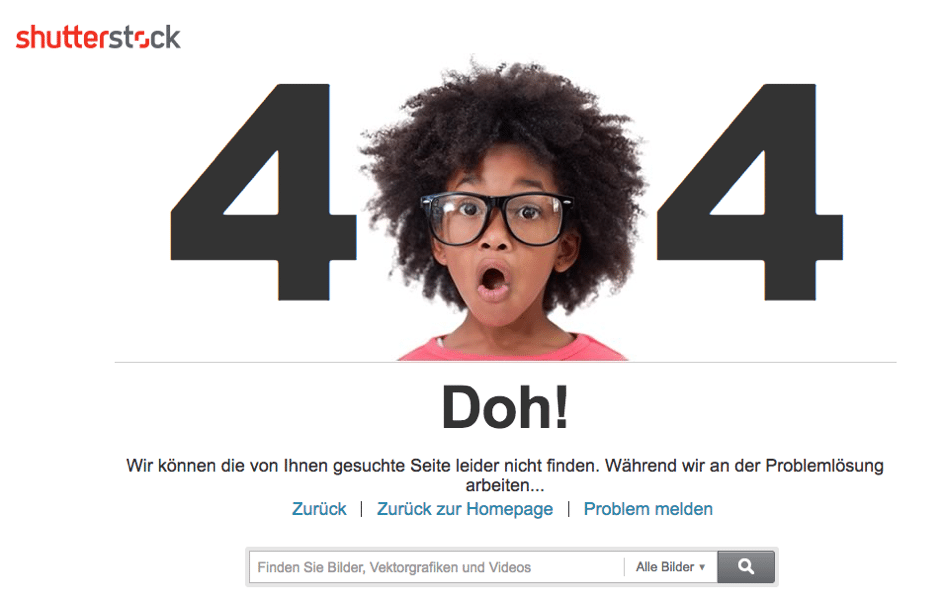

6. 404 Fehler

404 Fehler werden auf der Website ausgespielt, wenn die Inhalte von URLs nicht mehr vorhanden sind. Der Nutzer wird dann auf die 404 Seite geführt. 404 Fehler entstehen durch fehlende oder fehlerhafte Redirects oder fehlerhafte Verlinkungen. Um eine Verschwendung der Linkkraft vorzubeugen und ein gutes Nutzererlebnis zu bieten, muss die Webseite regelmässig auf 404 Fehler geprüft und die URLs weitergeleitet werden.

7. Broken Links

Als Broken Links gelten interne Verlinkungen, welche auf eine nicht erreichbare Seite zeigen. Die Nutzer werden über eine solche Verlinkung direkt auf eine 404 Seite (siehe Punkt 6) geführt. Dies beeinträchtigt das Nutzererlebnis und führt zu Verschwendung von Linkkraft. Aus diesem Grund soll die Website regelmässig auf Broken Links geprüft werden.

8. URL Parameter

URL Parameter entstehen häufig durch Filter und Sortierfunktionen auf der Website oder User IDs. Aufgrund identischer Inhalte über mehrere URLs bilden diese Parameter Duplicate Content. Diese Parameter sollten in der Search Console gesperrt werden, damit sich die Suchmaschinen auf die wichtigen Inhalte konzentriert.

Fazit

Technisches SEO bildet die Grundlage für alle SEO Massnahmen.

Bevor spezifische Keywordoptimierungen angegangen werden, muss die technische Struktur der Website stimmen. Denn alle weiteren SEO Schritte werden darauf aufgebaut. Es empfiehlt sich, die technischen Komponenten der Website mit Hilfe einer professionellen SEO Agentur regelmässig zu prüfen, um Sichtbarkeitsverluste vorzubeugen und Fehler sofort zu beheben.

Sie möchten eine technische Analyse Ihrer Seite? – Wir beraten Sie!

Mitwirkende:

Strategische Geschäftsfelder: Suchmaschinenoptimierung

Teile diesen Beitrag, wähle deine Plattform:

Weitere spannende Artikel

- Marketing Konzept oder Marketing Strategie ist die Frage nach des Pudels Kern!admin2021-07-27T13:03:18+00:00

- User Experience: 10 Wege die Nutzerführung auf einer Webseite mit kleinem Aufwand zu verbessernadmin2021-07-28T08:57:18+00:00